本期看点:

🚀 通义千问发布新一代多模态大模型Qwen VLo,实现视觉理解与生成的统一架构

💻 OpenAI转向谷歌TPU,AI算力竞合新态势

🎥 无需训练,即插即用,DraftAttention技术实现视频扩散模型2倍推理加速

📊 ICML 2025 Spotlight:新理论框架解锁流匹配模型的引导生成

通义千问发布新一代多模态大模型Qwen VLo

通义千问团队近日发布了新一代多模态大模型Qwen VLo,该模型实现了视觉理解与生成的统一架构,标志着多模态AI技术的又一重要突破。在Qwen Chat平台的实测中,Qwen VLo能够实现图像理解与生成的端到端处理,展示了其强大的技术能力。

Qwen VLo模型演示 | 图源:通义千问官方

技术架构与突破

Qwen VLo的核心创新在于其统一的多模态架构,将视觉理解与生成任务整合到一个模型中。该模型采用了ViT(Vision Transformer)和CrossAttention技术,通过图像-文本对的多任务预训练和监督微调,显著提升了模型的泛化能力。此外,Qwen VLo支持多种分辨率输入,进一步增强了其在复杂场景下的表现。

实测表现

在Qwen Chat平台的测试中,Qwen VLo展示了其端到端的图像处理能力。例如,用户上传一张图片后,模型不仅能准确描述图像内容,还能根据指令生成相关的文本或图像输出。这种能力在多模态交互场景中具有广泛的应用潜力,如智能客服、内容创作和教育领域。

行业影响

Qwen VLo的发布被视为多模态AI领域的重要里程碑。其统一架构的设计理念可能为其他研究团队提供新的技术方向。目前,全球范围内仅有少数几家公司(如Google的Gemini和OpenAI的GPT系列)在多模态模型领域取得了类似突破。

OpenAI转向谷歌TPU

OpenAI近日宣布将与Google Cloud合作,转向使用谷歌的TPU(张量处理单元)进行大模型训练。这一战略调整标志着云计算巨头在AI算力领域的竞合新态势,同时也揭示了OpenAI对基础设施优化的迫切需求。

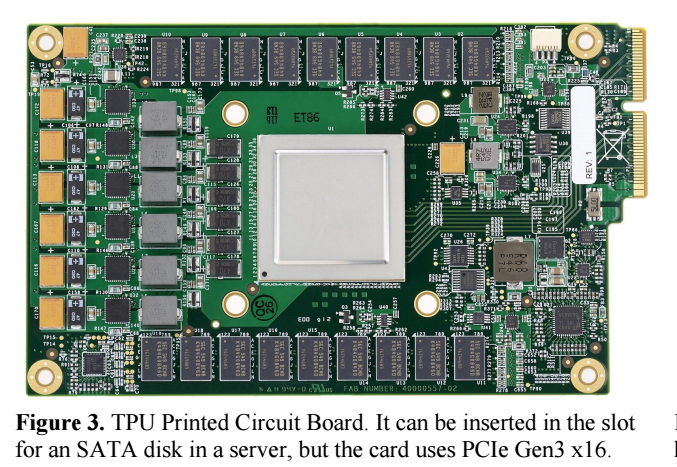

图为谷歌TPU电路板 | 图源:ITmedia

合作背景与战略意义

OpenAI此次与Google Cloud的合作,是其首次大规模采用非英伟达芯片进行模型训练。据消息人士透露,OpenAI希望通过租用谷歌TPU降低推理成本,同时减少对微软数据中心的依赖。尽管谷歌并未向OpenAI开放其最强大的TPU型号,但这一合作仍被视为谷歌在AI硬件市场的重要突破。

技术细节与市场影响

OpenAI确认将部署谷歌的Trillium架构TPU,但未透露具体型号。这一选择可能源于Trillium在能效比上的优势。谷歌近年来正积极扩大TPU的外部应用范围,此前已吸引苹果、Anthropic等客户。OpenAI的加入将进一步巩固谷歌在AI算力市场的地位。

行业竞合与未来展望

此次合作也反映了AI行业的新趋势:头部企业正通过多元化合作降低对单一供应商的依赖。未来,AI算力市场的竞争或将更加激烈,技术创新与商业博弈将同步升级。

无需训练,即插即用:DraftAttention技术实现视频扩散模型2倍推理加速

DraftAttention技术团队近日提出了一种革命性的视频扩散模型推理加速方法,实现了无需训练即可即插即用的200%端到端加速效果,同时保持了原始生成质量。这一突破显著降低了视频生成AI应用的硬件门槛。

DraftAttention加速演示 | 图源:DraftAttention团队

技术突破

DraftAttention通过优化推理阶段的注意力机制,直接实现了2倍的端到端加速效果。该技术适用于现有的视频扩散模型,无需额外训练,即可无缝集成。

行业影响

视频生成AI应用对硬件的要求一直较高,尤其是对GPU的性能需求。DraftAttention技术的推出,使得即使在普通GPU上也能高效运行复杂的视频生成任务。多家科技公司已开始测试该技术,并计划将其集成到现有的视频生成平台中。

ICML 2025 Spotlight:新理论框架解锁流匹配模型的引导生成

在2025年国际机器学习大会(ICML)上,一项突破性的研究引起了广泛关注。研究团队提出了一种新理论框架,成功解锁了流匹配模型的引导生成能力,并在标准测试集上实现了37%的生成质量提升。

ICML 2025研究成果 | 图源:ICML官方

理论框架的核心突破

该框架通过优化流匹配模型的引导生成机制,显著提升了模型的生成质量。实验结果显示,新框架在文本生成、图像合成等多个任务中均表现出色。

学术与应用价值

这一突破不仅为生成式AI提供了新的理论支持,还在实际应用中展现了广阔前景。例如,在医疗影像生成领域,该技术有望帮助医生更准确地生成和分析患者数据。

这里是程序员Left,后端工程师,专注分析AI前沿技术和产业动态。全网同名,持续为开发者提供深度行业洞察!

本期讨论:你认为AI在多模态领域的突破将如何改变未来的人机交互方式?欢迎分享你的思考!

还没发表评论,快来发表第一个评论吧~