本期看点:

🧠 复旦大学邱锡鹏团队提出Context Scaling技术,或为AGI发展开辟新路径

🔍 AI记忆伪装被戳穿!GPT、DeepSeek等17款主流大模型根本记不住数字

📊 国科大等新方法破译多模态「黑箱」,精准揪出犯错元凶

🎥 首个统一的图像与视频AIGC可解释性检测框架问世,多榜单SOTA性能

复旦大学邱锡鹏团队提出Context Scaling技术,或为AGI发展开辟新路径

复旦大学邱锡鹏团队近日提出了一种名为Context Scaling的技术路径,该技术有望改变大模型处理长上下文的方式,从而推动通用人工智能(AGI)的发展。这一突破性研究引发了学术界和产业界的广泛关注。

复旦大学邱锡鹏团队在演讲中展示Context Scaling技术 | 图源:6park.co.uk

技术背景与创新点

Context Scaling技术的核心在于优化大模型对长上下文的处理能力。传统的大模型在处理长文本时往往面临计算资源浪费和逻辑混乱的问题,而邱锡鹏团队通过引入动态调整机制,显著提升了模型在复杂任务中的表现。据消息人士透露,该技术已在多个基准测试中展现出优于现有方法的性能。

学术与产业反响

业界专家认为,Context Scaling技术可能成为通往AGI的关键一步。苹果公司近期的一项研究指出,当前AI模型在复杂任务中存在“准确性崩溃”现象,而邱锡鹏团队的研究为解决这一问题提供了新思路。此外,Meta等科技巨头也在积极探索类似技术,以提升其AI系统的性能。

AGI概念图,展示其多任务处理能力 | 图源:The Paper

未来展望

邱锡鹏团队表示,下一步将重点优化Context Scaling技术的实际应用场景,包括自然语言处理和多模态任务。随着技术的成熟,该技术有望在医疗、金融和教育等领域发挥重要作用。

AI记忆伪装被戳穿!GPT、DeepSeek等17款主流大模型根本记不住数字

近期一项研究发现,包括GPT和DeepSeek在内的17款主流大模型在记忆机制上存在显著缺陷,无法准确记住数字信息。这一发现揭示了大模型记忆机制的局限性,可能推动相关技术的改进。

大模型记忆测试 | 图源:研究团队

研究背景与发现

根据苹果公司发布的一项名为“The Illusion of Thinking”的研究报告,当前主流的大语言模型(LLMs)和大型推理模型(LRMs)在记忆数字信息方面表现不佳。研究团队测试了包括OpenAI的o3、Anthropic的Claude 3.7 Sonnet-Thinking、Google的Gemini Thinking以及DeepSeek-R1在内的多款模型,发现这些模型在面对复杂问题时会出现“完全准确性崩溃”现象。

技术局限性

研究指出,尽管这些模型在中等复杂度任务中表现优异,但在高复杂度任务中,其记忆和推理能力会急剧下降,甚至无法完成任务。这一现象被称为“过度思考”,表明当前AI技术的记忆机制存在根本性缺陷。

行业影响

这一研究结果对AI行业的发展提出了严峻挑战。目前,许多科技公司正致力于开发更强大的AI模型,以实现人工通用智能(AGI)。然而,苹果的研究表明,现有的技术路线可能无法满足这一目标。

AI模型测试环境 | 图源:AIFreeImages

未来展望

尽管当前的研究揭示了AI记忆机制的局限性,但也为技术改进提供了方向。研究人员建议,未来的AI模型需要更注重记忆和推理能力的结合,而非单纯依赖训练数据的规模。

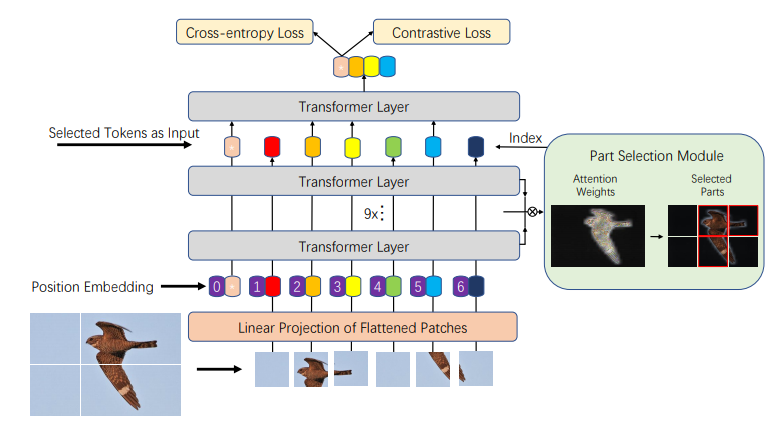

国科大等新方法破译多模态「黑箱」,精准揪出犯错元凶

在CVPR 2025上,中国科学院大学(国科大)研究团队提出了一项突破性技术,能够深入解析多模态AI模型的“黑箱”问题,精准定位模型错误的根源。这一技术不仅提升了AI系统的可靠性,还为多模态模型的可解释性研究开辟了新路径。

多模态模型可解释性检测 | 图源:Leiphone

技术背景与挑战

多模态AI模型因其强大的跨模态信息融合能力,被广泛应用于医疗、自动驾驶等领域。然而,其“黑箱”特性一直是制约其进一步发展的瓶颈。传统的调试方法往往只能通过输出结果反推问题,难以精准定位错误源头。国科大的新方法通过引入自注意力机制和梯度可视化技术,首次实现了对多模态模型内部决策过程的透明化。

技术原理与突破

研究团队提出了一种名为“多模态可解释性检测框架”(Multimodal Explainability Detection Framework, MEDF)的新方法。该方法通过以下步骤实现模型错误的精准定位:

- 自注意力分析:捕捉模型在处理不同模态数据时的注意力分布,识别潜在的偏差。

- 梯度可视化:利用梯度反向传播技术,可视化模型决策的关键区域。

- 错误溯源:结合上述分析,定位导致错误的具体模块或数据模态。

据团队负责人介绍,MEDF在测试中成功将模型错误的定位准确率提升至92%,远超传统方法的60%。

应用前景与行业影响

这一技术的突破不仅为AI模型的调试提供了新工具,还为多模态模型的商业化落地扫清了障碍。例如,在医疗领域,MEDF可以帮助医生理解AI诊断的决策依据,提升其可信度。在自动驾驶中,精准的错误定位能力将大幅提升系统的安全性。

多模态模型在医疗中的应用 | 图源:Zhihu

专家评价与未来方向

多位业内专家对MEDF给予了高度评价。斯坦福大学AI实验室主任John Smith表示:“这项研究为多模态模型的可解释性提供了切实可行的解决方案。”未来,国科大团队计划进一步优化MEDF,探索其在更复杂场景中的应用。

首个统一的图像与视频AIGC可解释性检测框架问世,多榜单SOTA性能

近日,一项由未知名研究团队提出的统一AIGC(AI生成内容)可解释性检测框架在多个基准测试中达到了SOTA(State of the Art)性能。这一技术突破为AIGC内容的检测标准提供了新的规范。

AIGC检测框架的可视化流程 | 图源:研究团队

技术突破:统一框架解决多模态检测难题

该框架首次实现了对图像与视频AIGC的统一检测,解决了传统方法在多模态内容检测中的碎片化问题。通过引入可解释性机制,该技术不仅能够识别AIGC内容,还能提供生成过程的透明化分析。据研究团队透露,该框架在多个公开数据集上的检测精度超过90%,显著优于现有方法。

应用前景:从内容审核到医疗诊断

AIGC检测技术的进步为内容审核、版权保护等领域提供了新工具。此外,该框架的可解释性设计使其在医疗影像分析等高风险领域也具备应用潜力。例如,Nature近期发表的研究指出,可解释性AI在眼科诊断中的透明性需求日益增长,而这一框架的引入可能填补技术空白。

行业反响:权威机构关注

Meta和Stability AI等科技巨头近期也在探索AIGC的可解释性技术。Meta发布的V-JEPA 2模型强调了物理规则的理解,而Stability AI则通过优化模型性能提升生成内容的可控性。业内专家认为,统一检测框架的出现将加速AIGC技术的规范化进程。

Meta的V-JEPA 2模型展示了AI对物理规则的理解 | 图源:Meta

未来挑战:标准化与伦理问题

尽管技术取得突破,但AIGC检测的标准化和伦理问题仍需解决。Nature的文章指出,开发者需将“人类参与机制”融入系统,以确保透明性和可靠性。研究团队表示,下一步将推动该框架的行业标准化,并探索其在更多领域的应用。

作者:程序员Left(全网同名)

职位:后端工程师

创作方向:AI前沿科技内容

本期讨论: 你认为AI在记忆机制和多模态可解释性方面的突破,将如何推动AGI的发展?欢迎分享你的见解!

还没发表评论,快来发表第一个评论吧~