本期看点:

🧠 蚂蚁集团进化算法破局KV Cache内存瓶颈

🎤 LLaSO开源框架定义语音大模型新基准

蚂蚁集团玩转进化算法,大模型内存占用暴跌至1.5%!

蚂蚁集团的研究团队这回可真是放大招了!他们在优化大模型推理上搞了个大突破,用进化算法捣鼓KV Cache机制,硬是把内存占用从往常的20-40%压到了惊人的1.5%。这简直是里程碑式的进展,意味着大模型推理不再那么吃内存,为那些资源紧张的场景打开了新大门。

KV Cache(键值缓存)可是大语言模型推理时耗内存的大户,传统方法动不动就占20-40%的显存,一直让大家头疼。蚂蚁团队耍了个聪明,用进化算法优化缓存分配策略,既保住了推理质量,又把内存压缩到了极限。核心秘密在于他们的LayerKV执行引擎,玩起了预留分配、智能卸载和动态调度这些花活,让内存效率飙升。

图为LayerKV架构设计示意图 | 图片来源:知乎

实测下来,这方案不光省内存,还大幅降低了延迟,某些场景下性能提升了10到17倍!具体来说,推理质量不变,内存占用从20-40%降到1.5%,同时QPS提升了2.5倍,延迟降低了23.3倍。这种全方位优化,实用性爆表!

这时候爆出这技术,正赶上全球AI基础设施投资火热。报告说美国数据中心建设花了破纪录的400亿美元,科技巨头们都在疯狂扩张。蚂蚁这手KV Cache优化,正好解决了AI推理内存消耗高的痛点,随着模型越来越大,提升内存效率直接关系到成本和电费,太及时了!

LLaSO开源框架横空出世,语音大模型迎来统一标准!

逻辑智能公司最近放了个大招,发布了全球首个完全开源的语音大模型框架LLaSO,这为LSLM(大规模语音语言模型)研究立下了新标杆。这个里程碑式的发布,让语音AI领域的开发者们有了统一的训练和评估工具,大大推动了多模态语音技术的开放发展。

LLaSO的推出,意味着语音大模型技术正式迈入开源时代。现在,开发者不用再从零搭建复杂的语音处理系统,就能拿到完整的训练流程、评估标准和模型架构。它支持语音识别、合成、理解等多种核心任务,提供端到端的解决方案,简直是研究者的福音。

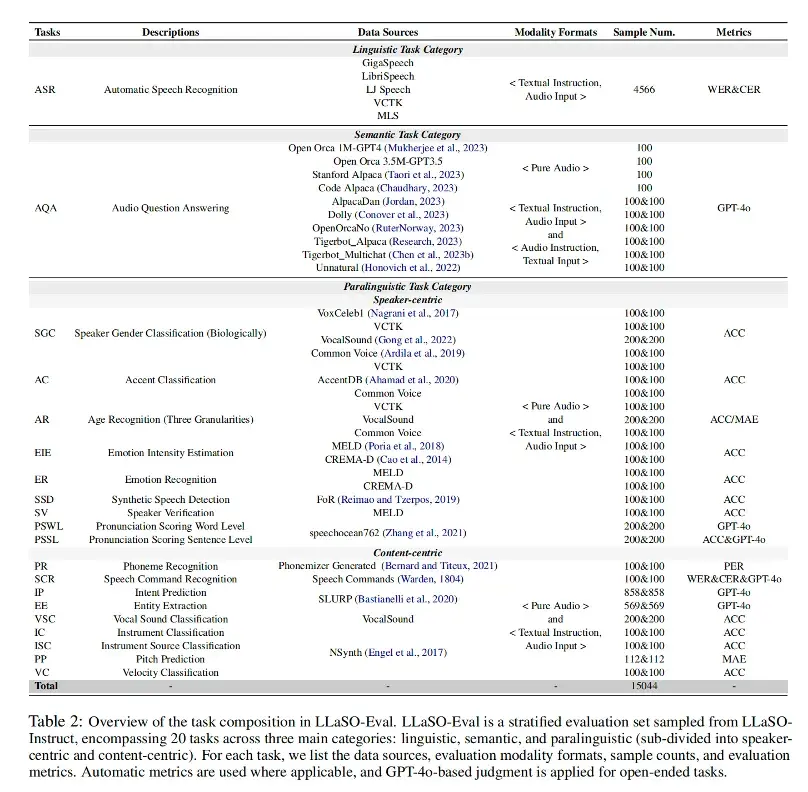

图为LLaSO-Eval任务构成详细分类 | 图片来源:知乎

技术层面,LLaSO搞了个先进的评估体系叫LLaSO-Eval,把语音任务科学地分成四类:语言学任务、语义学任务、副语言学任务以及内容中心任务。这种分类让不同模型的比较有了统一标准。框架支持纯音频、音频-文本、文本-音频等多种模态配置,评估指标涵盖了ASR(自动语音识别)、CER(字符错误率)、GPT-4+评分等关键维度。

性能上,LLaSO在多个测试中表现亮眼。在11个开源模型的比拼中,它在不同配置下都显示出优势,尤其在语义理解和语言生成任务上突出。它还支持大规模多语言语音处理,能搞定中文、英文等,实用性很强。

图为LLaSO开源框架宣传图 | 图片来源:iaiol

眼下开源AI模型正火,LLaSO来得正是时候。开源给了企业和机构更多灵活性,特别是在数据安全和定制化方面。LLaSO采用完全开放许可,开发者可以自由使用、修改和分享,这肯定会加速语音AI的创新。它还提供了详细文档和代码示例,帮助大家快速上手做实验。

这两项突破,一个从硬件资源下手,一个在软件框架上立规矩,都在推动AI技术向前跑。蚂蚁集团的KV Cache优化解决了大模型部署的燃眉之急,LLaSO开源框架则为语音AI设立了统一标准,让AI变得更高效、更开放。

作者:程序员Left(全网同名)

职位:后端工程师

创作方向:AI前沿科技内容

我是程序员Left,爱捣鼓AI底层技术,如果你也有心得,快来评论区聊聊!

本期讨论:你觉得,是死磕性能优化更重要,还是大力推广开源对AI长远发展更有利?来,说出你的看法!

还没发表评论,快来发表第一个评论吧~