嘿,朋友们!基于最新搜索,我为你带来一期超有趣的AI新闻深度总结,保证让你大开眼界!

本期看点:

🚀 Arm放大招!Lumex CSS平台让移动AI算力直接翻五倍,手机变身超级电脑不是梦

📱 Meta开源神器MobileLLM-R1,小身材大能量,十分之一训练量干翻大模型

🧠 清华天团出手!推理RL超全综述出炉,超级智能路线图清晰可见

💬 快手可灵MIDAS框架玩转压缩魔法,64倍瘦身还保持500ms闪电响应

Arm Lumex CSS:移动AI的性能怪兽来袭!

芯片大佬Arm最近扔出了一颗重磅炸弹——全新的Lumex CSS(Compute Subsystem)平台。这玩意儿可不是小打小闹,它在移动设备和边缘计算领域直接来了个性能大跃进!官方数据亮瞎眼:相比上一代,性能飙升5倍,能效还提升了3倍,简直就是给终端AI应用装上了火箭引擎。

Arm Lumex CSS平台架构示意图 | 图片来源:电子工程专辑

扒开技术内幕,Lumex平台整合了最新的AArch64 CPU,加持了可扩展矩阵扩展2(SME2)技术,还有全新的Mali G1-Ultra GPU IP。具体来说,AI性能提升5倍,语音延迟降低4.7倍,音频生成快2.8倍。C1 Ultra CPU单线程性能涨了25%,年同比IPC两位数增长——这意味着你的手机明年就能本地运行超复杂AI模型,从实时翻译到高级修图,体验直接起飞!

更劲爆的是,Lumex CSS预计2026年登陆高端Android手机,电池续航还不掉链子。这平台专为AI优化,通过新CPU集群和GPU架构,把桌面级AI性能塞进了消费设备。眼下Arm正和Qualcomm掐得火热,Lumex的推出无疑是Arm的强势回归,在移动AI计算领域立下了新标杆。

Meta MobileLLM-R1:小而美的移动端AI奇迹

Meta这次开源了MobileLLM-R1模型,简直是小身材爆发出大能量!这个不到10亿参数的紧凑模型,只用十分之一的训练量,就轻松超越了Qwen3的性能,真是“四两拨千斤”的典范。

MobileLLM-R1与其他开源模型性能对比 | 图片来源:新浪科技

MobileLLM-R1在数学推理、代码生成、多模态理解等测试中表现抢眼,尤其在资源紧张的环境下效率超高。这种压缩优化技术让高性能AI真正走进终端,不用再担心云端延迟和隐私问题。Meta的开源策略更是给开发者送福利,移动端AI开发门槛大幅降低。

从技术趋势看,MobileLLM-R1代表了效率优化的新方向。在计算资源宝贵、隐私至上的今天,这种小参数模型实用价值爆表,不仅降低了AI应用成本,还推动了AI技术的普惠化。

清华大学领衔:推理模型RL技术路线图大揭秘

清华大学和上海AI Lab联手发布了推理模型强化学习(RL)的超全综述,系统梳理了这一前沿领域的发展路径。这份综述为超级智能提供了扎实的理论基础,从基础组件到高级概念,覆盖完整技术栈。

推理模型RL技术发展时间线 | 图片来源:新浪科技

研究团队详细分析了2022到2025年的技术演进,包括人类反馈RL、直接偏好优化等关键突破。这份综述不只是总结,更绘制了未来研究方向,为AI推理能力提升指明道路。从技术脉络看,推理RL正从简单奖励优化向复杂认知架构演进,为真正智能的AI系统奠基。

快手可灵MIDAS:多模态交互的延迟杀手

快手可灵团队推出的MIDAS多模态互动数字人框架,在压缩和响应上实现了惊人突破。64倍压缩比,生成延迟压到500毫秒以内,为实时交互应用提供了可行方案。

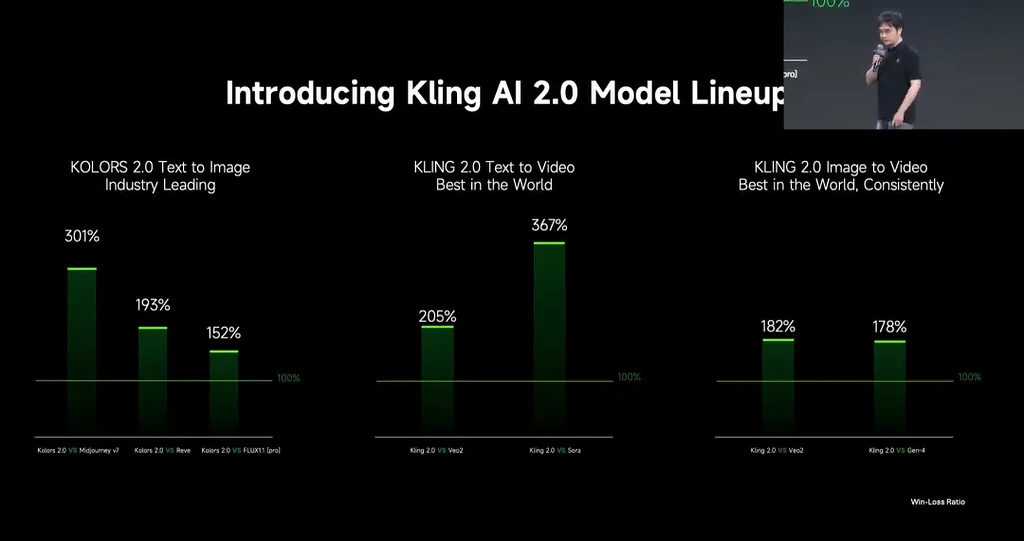

可灵AI模型架构示意图 | 图片来源:AI资讯

MIDAS框架的价值在于解决了多模态生成的计算复杂度和延迟问题,让数字人交互近乎实时。这对虚拟助手、在线教育、直播等场景意义重大。技术上看,64倍压缩意味着高质量输出同时大幅降低资源需求,500毫秒延迟让交互体验流畅如丝。

从芯片算力爆发到模型效率优化,从理论梳理到应用创新,这周的AI进展全方位开花。Arm的硬件革新给终端AI加buff,Meta的模型优化证明小也能强,学术界的系统研究指路未来,工业界的应用让技术落地生根。

硬件、软件、理论、应用四管齐下,正是AI技术成熟普及的关键。随着这些突破,AI将在更多场景中大放异彩,真正成为改变生活的核心力量。

作者:程序员Left(全网同名)

职位:后端工程师

创作方向:AI前沿科技内容

如果你对移动端AI部署的技术细节感兴趣,或者在实际项目中遇到过类似的性能优化挑战,欢迎在评论区分享你的经验和见解!一起来聊聊吧~

本期讨论:在终端设备算力受限的现实条件下,模型架构优化和硬件性能提升哪个才是解决AI部署难题的更优路径?你的看法是?

还没发表评论,快来发表第一个评论吧~